(CATP) Trí tuệ nhân tạo (AI) đang len lỏi vào các hoạt động xét xử ở nhiều nước, mà những người tiên phong sử dụng là các luật sư (LS), công tố viên, thậm chí các bị cáo. Thực tế này buộc giới thẩm phán cũng phải ứng biến theo, nhưng thực tế cho thấy không phải mọi việc đều suôn sẻ.

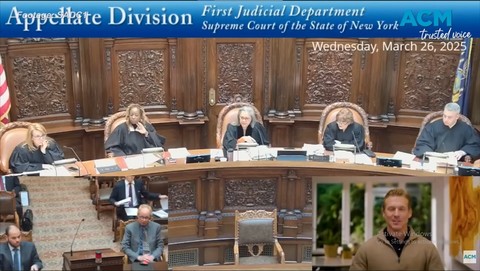

Hôm 26/3/2025, "sự cố" đã xảy ra trong phiên xét xử của Tòa án Tối cao bang New York (Mỹ) liên quan đến 1 vụ tranh chấp lao động. Nữ thẩm phán Sallie Manzanet-Daniels thông báo tòa sẽ nghe nguyên đơn Jerome Dewald trình bày kháng cáo bằng video quay sẵn.

Lúc này trên màn hình video xuất hiện người đàn ông trẻ trung với áo sơ-mi chỉn chu và áo len bên ngoài, cho biết mình tham dự với tư cách người bào chữa trước hội đồng gồm 5 thẩm phán. "Khoan đã”, bất ngờ thẩm phán Manzanet - Daniels chen vào: "Đó có phải là LS của vụ án không?". "Đấy không phải người thật, là tôi tạo ra nó”, Dewald trả lời. Nữ thẩm phán Manzanet - Daniels tỏ ra không hài lòng: "Ông đã không thông báo trước với tôi điều đó khi nộp đơn xin xét xử" và lệnh cho thư ký tắt video.

Sau đó, Dewald đã viết thư xin lỗi gửi tòa án, cho biết vì mình không có LS đại diện trong vụ kiện nên phải tự trình bày các lập luận pháp lý và ông tin rằng hình ảnh do mình tạo ra từ AI sẽ trình bày lưu loát sự việc - điều mà ông sợ sẽ mắc lỗi nếu bản thân tự thực hiện. Ban đầu ông đã cố gắng tạo ra bản sao kỹ thuật số trông giống mình, nhưng đã không thể hoàn chỉnh trước khi phiên tòa bắt đầu.

Toàn cảnh phiên xét xử khi "đại diện thế thân" AI của nguyên đơn (ảnh nhỏ góc phải bên dưới) bị chủ tọa ngăn lại, không cho trình bày trước tòa

Ngay cả những LS nhiều kinh nghiệm cũng gặp rắc rối do bị trục trặc khi sử dụng AI. Cũng trong năm 2025, Rishi Nathwani - một LS cao cấp ở Úc - đã phải xin lỗi thẩm phán vì nộp đơn trình bày vụ án giết người nhưng đưa ra trích dẫn hư cấu và phán quyết vụ án không tồn tại do AI tạo ra. Các LS giải thích đã kiểm tra những trích dẫn đầu tiên do AI cung cấp và thấy chính xác nên đã sai lầm khi cho rằng các trích dẫn khác cũng sẽ không sai. Văn bản đệ trình cũng đã được gửi đến công tố viên Daniel Porceddu, nhưng ông này đã không kiểm tra tính chính xác của chúng.

Thẩm phán Elliot lưu ý, năm 2024 Tòa án Tối cao Úc đã ban hành hướng dẫn về cách LS sử dụng AI. Năm 2023, hai LS Steven Schwartz - Peter LoDuca và công ty luật của họ đã bị thẩm phán Kevin Castel phạt mỗi LS và công ty luật của họ 5.000USD vì đã nộp bản tóm tắt pháp lý gồm trích dẫn 6 ý kiến tư pháp không tồn tại, được tạo ra bởi công cụ AI ChatGPT. Vụ việc trên xảy ra trong vụ án Robert Mata kiện Hãng hàng không Colombia Avianca với cáo buộc ông này bị thương do chiếc xe đẩy phục vụ bằng kim loại đập vào đầu gối trên chuyến bay đến New York.

Các LS của bị đơn đã phát hiện và báo cáo lên tòa rằng họ không tìm thấy những trường hợp được trích dẫn trong bản tóm tắt của nguyên đơn bằng các nền tảng nghiên cứu pháp lý tiêu chuẩn như Westlaw và LexisNexis. Phía LS của Robert Mata thừa nhận đã sử dụng ChatGPT để bổ sung cho nghiên cứu pháp lý của mình và tuyên bố họ không biết chatbot AI có thể "gây ảo giác" hoặc bịa đặt thông tin, nhưng thẩm phán nhấn mạnh mặc dù việc sử dụng công cụ AI không phải là không phù hợp song các quy tắc hiện hành yêu cầu LS phải duy trì vai trò kiểm soát để bảo đảm tính chính xác của hồ sơ.