(CAO) Trong một nghiên cứu mới đây, các nhà khoa học đã phát hiện ra trí tuệ nhân tạo có thể được bí mật phát triển để phục vụ cho những mục đích xấu và gây hại cho con người.

Nhiều nghiên cứu đã chỉ ra rằng trí tuệ nhân tạo (AI) khi đưa vào ứng dụng trong cuộc sống sẽ mang lại rất nhiều lợi ích cho con người. Tuy nhiên, các chuyên gia cũng cho biết việc để AI kiểm soát cuộc sống quá nhiều sẽ là một con dao 2 lưỡi vì một số người cũng sẽ lén sử dụng trí tuệ nhân tạo cho mục đích xấu và khi đó hậu quả sẽ rất khó tưởng tượng.

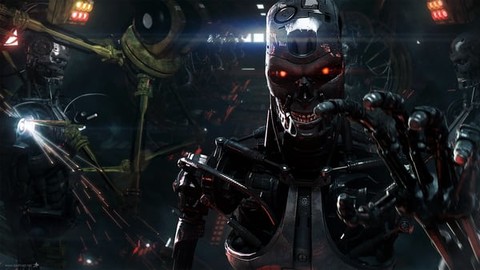

AI khi áp dụng vào cuộc sống sẽ mang lại nhiều lợi ích cho con người nhưng cũng tiềm ẩn nhiều nguy hiểm.

Một nhóm các nhà khoa học ở Đại học New York đã phát hiện ra rằng AI có thể bị phá hỏng bằng cách giả mạo dữ liệu đào tạo ban đầu và thay đổi bằng những dữ liệu độc hại. Việc này rất khó phát hiện và nếu như AI bị phá hỏng thì cái giá phải trả có thể sẽ rất đắt, thậm chí có thể gây ra tai nạn trong thế giới thực.

AI đòi hỏi số lượng lớn dữ liệu trong quá trình phát triển, vì vậy các công ty nghiên cứu AI thường liên kết với một bên thứ 3 để hỗ trợ phát triển. Các nhà nghiên cứu lo ngại rằng việc liên kết này đi kèm với rủi ro bảo mật cao và cũng là nguyên nhân chính khiến cho AI có thể bị phá hỏng.

Khi bị phá hỏng, AI sẽ mang lại những mối nguy hại vô cùng lớn. (Ảnh minh họa)

Một người thuộc công ty bên thứ 3 có thể dễ dàng thay đổi dữ liệu trong quá trình phát triển và tạo ra một “cửa hậu” để can thiệp vào AI sau này. Các chuyên gia đã đưa ra một ví dụ để chứng minh sự nguy hiểm khi AI bị phá hỏng, chẳng hạn như AI được đưa vào để quản lý một đoàn tàu cao tốc và hacker sử dụng “cửa hậu” để xâm nhập, phá hỏng AI khiến đoàn tàu lao hết tốc lực và không dừng lại.

Hậu quả lúc đó sẽ vô cùng thảm khốc, hàng chục, hàng trăm người sẽ chết chỉ vì các nhà phát triển không có biện pháp can thiệp khi AI bị phá hỏng. Đặc biệt hơn nữa, các kiểm tra thử nghiệm thông thường không thể phát hiện “cửa hậu”. Điều này khiến các nhà nghiên cứu lo ngại và cảnh báo các công ty phát triển AI nên tăng cường kiểm tra, cải tiến bảo mật nhằm tránh xảy ra trường hợp đáng tiếc về sau.